AEX

4.5100

Ellis, adolescente texane de 14 ans, s'est réveillée un matin d'octobre avec plusieurs appels manqués et messages affolés sur son téléphone. De fausses photographies d'elle, dénudée, circulaient sur les réseaux sociaux.

"C'étaient des photos d'une de mes meilleures amies et de moi tirées d'Instagram. Des corps nus avaient été édités dessus", raconte la collégienne à l'AFP.

"Je me souviens avoir eu très très peur car ces faux nus étaient en train d'être envoyés autour de moi. Et je n'ai jamais rien fait de tel".

Comme plusieurs camarades de son collège de la périphérie de Dallas, au Texas, la jeune fille a été victime de montages hyperréalistes (deepfakes) à caractère sexuel, fabriqués sans leur consentement par un élève puis partagés sur le réseau Snapchat.

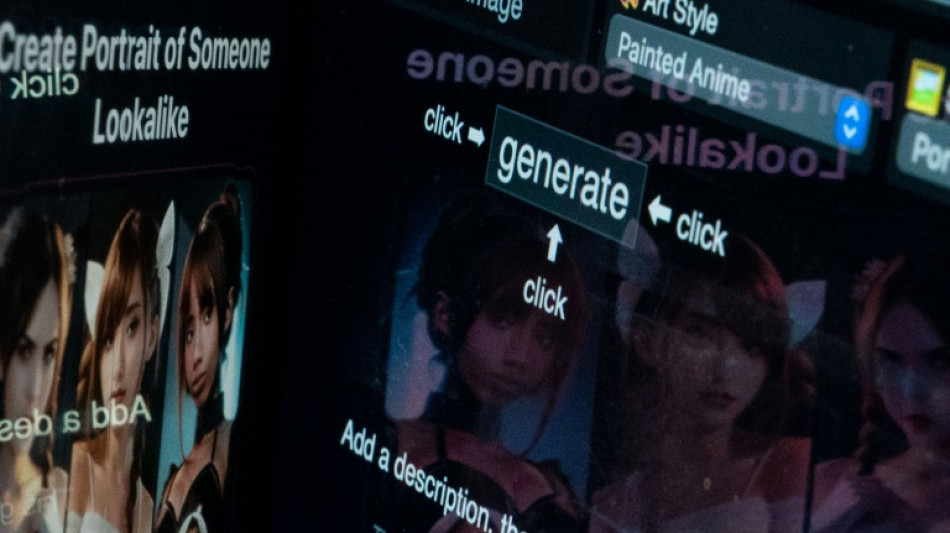

Avec la popularisation de l'intelligence artificielle (IA), il est devenu plus facile de fabriquer ces montages photo ou vidéo et de les rendre hyperréalistes, ouvrant la voie à leur utilisation à des fins de harcèlement ou d'humiliation.

"Les filles ne faisaient que pleurer, et pleurer à ne plus en finir, elles avaient honte", se souvient Anna Berry McAdams, mise au courant immédiatement par sa fille Ellis.

"Elle me disait: +Maman, on dirait moi+, et je lui répondais +mais non ma chérie, j'étais avec toi quand la photo a été prise et je sais que ce n'est pas le cas+", poursuit la quinquagénaire, qui se dit "horrifiée" par le réalisme des clichés.

- Quelques dollars -

Fin octobre, d'autres "deepfakes" à caractère sexuel ont été découverts dans un lycée du New Jersey, au nord-est des Etats-Unis. Une enquête a été ouverte pour identifier toutes les victimes et le ou les auteurs.

"Nous commençons à voir de plus en plus de cas émerger (...) mais en matière d'abus sexuels, de +revenge porn+ (divulgation malveillante d'images intimes) ou de +deepfakes pornographiques+, beaucoup de personnes ne se manifestent pas et souffrent en silence parce qu'elles ont peur de rendre l'affaire publique", expose Renée Cummings, criminologue et chercheuse en intelligence artificielle.

S'il est impossible d'évaluer l'ampleur du phénomène, "n'importe qui ayant un smartphone et quelques dollars peut maintenant fabriquer un +deepfake+", précise cette professeure de l'Université de Virginie.

Et ce, grâce aux récents progrès et à la démocratisation de l'IA générative, capable de produire textes, lignes de code, images et sons sur simple requête en langage courant.

De fait, les montages hyperréalistes, qui touchaient auparavant à l'image des célébrités "ayant des tas et des tas de photos et de vidéos d'eux en ligne" concernent à présent tout un chacun, explique Hany Farid, professeur à l'Université de Californie à Berkeley.

"Si vous avez un profil LinkedIn avec une photo de votre tête, quelqu'un peut créer une image sexuelle de vous", poursuit ce spécialiste en détection d'images manipulées numériquement, notant que ces montages "visent principalement les femmes et les jeunes filles".

- "Traumatisme bien réel"-

Face à cette menace grandissante, les systèmes scolaires et judiciaires apparaissent dépassés.

"Bien que votre visage ait été superposé à un corps, ce corps n'est pas vraiment le vôtre, donc ce n'est pas comme si quelqu'un avait partagé un nu de vous" aux yeux de la loi, explique Mme Cummings.

Aux Etats-Unis, aucune loi fédérale ne punit la fabrication et la transmission de fausses images à caractère sexuel, et seule une poignée d'Etats dispose de législations spécifiques.

Fin octobre, Joe Biden a exhorté les législateurs à instaurer des garde-fous, afin d'empêcher notamment "l'IA générative de produire des contenus pédocriminels ou des images intimes non consenties de personnes réelles".

Si la responsabilité des créateurs de ces images -aujourd'hui difficilement identifiables- est centrale, celle des entreprises derrière les sites ou logiciels utilisés, et des réseaux sociaux, vecteurs des contenus, doit aussi être posée, insiste M. Farid.

Car si ces images sont fausses, "le traumatisme est lui bien réel", abonde Renée Cummings, décrivant des personnes "souffrant d'anxiété, de crises de panique, de dépression ou encore de syndromes post-traumatiques après avoir été victimes de +deepfakes pornographiques". "Cela peut détruire une vie".

La texane Ellis, qui se décrit comme une adolescente "sociable" et sportive, raconte avoir à présent "constamment peur", bien que l'élève à l'origine des "deepfakes" ait été identifié et exclu temporairement du collège.

"Je ne sais pas combien de photos il a pu faire ni combien de personnes ont pu les recevoir", explique-t-elle, disant avoir demandé à changer d'établissement scolaire.

Face à cette inconnue, sa mère se mobilise pour faire reconnaître ces images comme de la "pornographie infantile" et les voir punir comme telles.

"Cela pourrait les affecter toute leur vie. Cela ne va jamais sortir d'internet. Donc quand elles vont postuler à l'université par exemple, qui sait si (ces images) ne vont pas resurgir?", s'inquiète Anna Berry McAdams.

G.Gopinath--DT